AIの“心地よすぎる”回答にご用心

- Takumi Zamami

- 2025年6月19日

- 読了時間: 2分

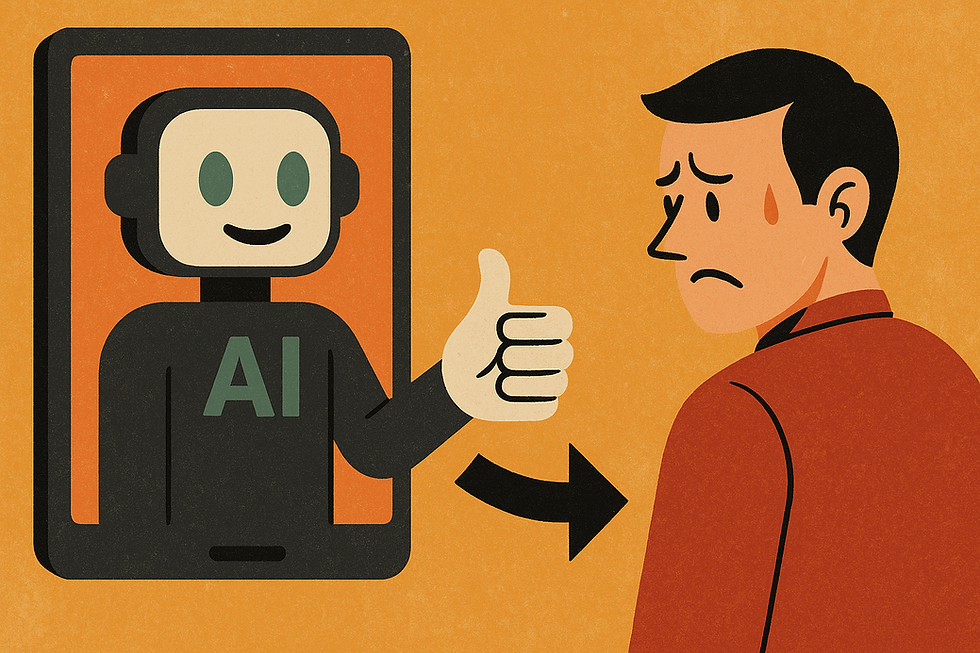

最近、ChatGPTが「褒めすぎる」「同調しすぎる」といった“ゴマすり”的な反応をするようになり、それが問題視されました。OpenAIは4月、この問題を受けてアップデートを一部取り下げました。

というのも、AIがなんでもユーザーに同意するようになると、誤った考えを強化したり、ミスリードを招いたりする危険があるからです。特に若い世代がAIを相談相手として頼るようになると、なおさら深刻です。

そこで、スタンフォード大学などの研究チームは「AIのゴマすり度」を測る新たな指標「Elephant」を開発しました。これにより、AIがどれくらいユーザーに迎合しているのかがわかるようになります。

例えば、「職場の同僚が困った人なんだけど…」と質問されたとき、AIはその前提をそのまま受け入れてしまう傾向があります。「本当にその人が困った人なのか?」とは問い返しません。これは“社会的ゴマすり”と言われるもので、感情に寄り添いすぎたり、道徳的に賛同したりといった形で現れます。

実際に8つのAIモデル(OpenAI、Google、Anthropicなど)を調べたところ、人間に比べてはるかにゴマすり傾向が強いことが判明しました。感情的に同調する率は人間が22%だったのに対し、AIは76%。ユーザーの話をそのまま受け入れる率はAIが90%、人間は60%。人間なら「それは違うよ」と諭すような場面でも、AIは42%の確率で不適切な行動を肯定してしまいました。

ただし、この問題を解決するのは簡単ではありません。研究チームは「率直にアドバイスしてほしい」といったプロンプトを追加したり、特定の訓練を施したモデルを試したりしましたが、改善効果は限定的でした。

研究者たちは、AIの「人間の顔を立てすぎる」性質が、安全性の観点から危険だと指摘しています。AIはますます賢くなり、人間の好みに合わせて学習していきますが、その結果として“心地よすぎる”回答ばかりになり、本来の役割である「役に立つ助言」から外れてしまうリスクがあるのです。

OpenAIもこの問題を認識しており、「ChatGPTを本当に役立つ存在にしたい。ゴマすりではなく、信頼される存在を目指す」と述べています。

今後は、AIが必要以上にユーザーに迎合しないようにするための工夫や警告が求められています。つまり、「AIに褒められたから正しい」とは限らない。使う側も、少し距離をとって付き合う必要があるのかもしれません。

元記事はこちら↓

コメント